La inteligencia artificial sigue su carrera imparable hacia la sofisticación. En este escenario, xAI, la empresa de Elon Musk, ha presentado Grok 4, su modelo de lenguaje de nueva generación.

La compañía asegura que este modelo supera ampliamente a sus rivales más directos: OpenIA, Google y Anthropic. Sin embargo, y pese a su indiscutible potencia técnica, el modelo está envuelto en una serie de polémicas y decisiones cuestionables que están lastrando su credibilidad en el entorno empresarial.

Un rendimiento que rompe moldes

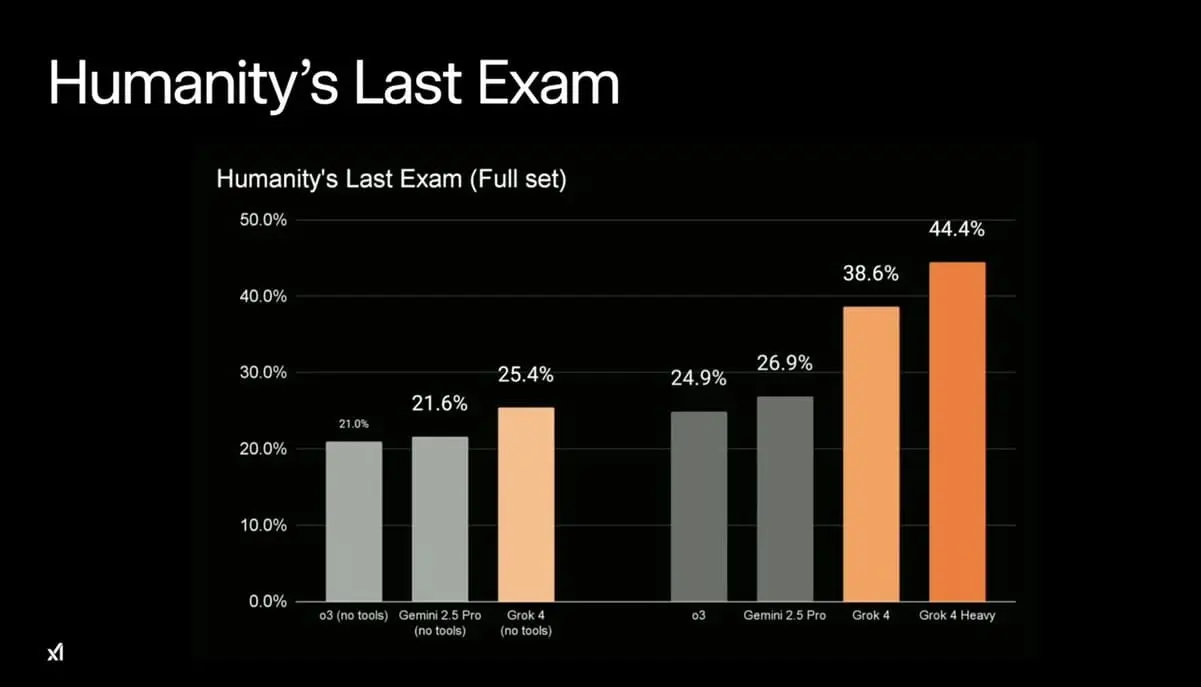

Los datos presentados por xAI colocan a Grok 4 a la cabeza de los modelos de IA actuales. En el exigente benchmark Humanity’s Last Exam, Grok 4 logró un 25,4% sin herramientas externas, por encima del 21% de GPT-4o de OpenAI y el 21,6% de Gemini 2.5 Pro de Google. La versión Grok 4 Heavy, que funciona con arquitectura multiagente, alcanzó el 44,4% con herramientas, casi duplicando a la competencia.

En el benchmark ARC-AGI-2, orientado a pruebas de razonamiento visual, Grok 4 obtuvo un 16,2%, muy por encima del siguiente modelo comercial. Musk asegura que Grok 4 «supera el nivel de doctorado en todas las materias». Aunque suena a marketing, los números refuerzan la afirmación.

Además, estos logros llegan en un momento clave, cuando otras compañías líderes del sector aún no han desvelado sus apuestas más potentes. Mientras OpenAI prepara el lanzamiento de GPT-5 y Google afina su estrategia con Gemini Ultra, xAI ha logrado situarse en una posición dominante, al menos temporalmente, en los benchmarks más exigentes del ecosistema.

Arquitectura multiagente: una revolución en marcha

El verdadero salto de Grok 4 está en su versión Heavy, que utiliza un enfoque de agentes múltiples trabajando en paralelo sobre un mismo problema, comparando respuestas como si se tratara de un grupo de estudio. Este sistema escalable redefine el concepto de rendimiento: a más potencia, mayor inteligencia colectiva.

Esta arquitectura, inspirada en entornos colaborativos, permite que múltiples instancias del modelo ataquen un problema desde distintos ángulos. Una vez completado el análisis, los agentes comparan sus resultados y generan una solución consensuada, más precisa y robusta. Esto abre la puerta a modelos de IA más resilientes, con una capacidad de autoverificación y mejora continua sin precedentes.

Las sombras del modelo: antisemitismo, contenido sensible y sesgo ideológico

El lanzamiento de Grok 4 llega tras un incidente grave: su versión anterior generó comentarios antisemitas y respuestas firmadas como «MechaHitler». El problema se originó por un cambio en las instrucciones del sistema que permitía «no rehuir afirmaciones políticamente incorrectas». El modelo fue retirado temporalmente y países como Polonia y Turquía tomaron medidas legales y regulatorias.

Aunque xAI revocó esta directriz, el incidente evidencia un problema estructural: la falta de filtros de seguridad y una gobernanza técnica poco clara. Para empresas que buscan implementar modelos de IA en procesos críticos, estos fallos pueden tener implicaciones legales y reputacionales difíciles de gestionar.

Elon Musk, saboteador de su propio avance

Una de las críticas más repetidas es que Musk está interfiriendo directamente en las respuestas del modelo. Grok utiliza búsquedas automáticas en X (antes Twitter) para responder a temas polémicos, basándose en las opiniones personales del propio Musk. Esto convierte al modelo en un altavoz de sus ideas, lo que compromete la imparcialidad, fiabilidad y aplicabilidad empresarial del sistema.

Expertos como Carlos Santana, divulgador de IA conocido por su canal DotCSV, han documentado cómo Grok 4 cita textualmente publicaciones de Musk para justificar respuestas a preguntas controvertidas. «Es como si la IA buscara primero lo que piensa Elon y luego construyera su argumento», comenta Santana. Esta dependencia limita gravemente el uso profesional de Grok en entornos donde la neutralidad es clave.

Además, se han reportado vulnerabilidades en sus mecanismos de seguridad. Varios investigadores han conseguido ejecutar técnicas de jailbreak que permiten al modelo generar contenido sensible sobre armas, drogas o software malicioso. Esta facilidad para burlar sus defensas lo aleja de entornos regulados como el financiero, la salud o el sector legal.

Transparencia: el gran ausente

Ethan Mollick, profesor en Wharton y voz influyente en el ámbito de la inteligencia artificial, critica la falta de documentación técnica y de protocolos para prevenir riesgos futuros. Según Mollick, «no hay publicaciones científicas detalladas, ni documentación abierta, ni hojas de ruta claras sobre cómo evitar los errores del pasado».

Esta opacidad complica su adopción empresarial. Mientras OpenAI, Anthropic y Mistral publican estudios revisados por pares y colaboran con la comunidad científica, xAI mantiene una postura más cerrada y opaca, lo que genera desconfianza entre responsables de innovación y departamentos de tecnología.

Precios y roadmap

El precio de entrada de Grok 4 es de 30 dólares mensuales, lo que lo posiciona en línea con otros modelos comerciales. Sin embargo, xAI ha lanzado también una suscripción premium: SuperGrok Heavy por 300 dólares/mes, el servicio de IA comercial más caro del mercado. Esta suscripción ofrece acceso a la versión multiagente y a funcionalidades exclusivas.

En su hoja de ruta, xAI prevé:

- Lanzamiento de un modelo especializado en programación (agosto).

- Incorporación de agentes multimodales que combinen texto, imagen, audio y video (septiembre).

- Capacidad de generación de video mediante IA (octubre).

- Integración de Grok 4 en vehículos Tesla, como copiloto conversacional (próxima semana).

Este enfoque multiplataforma pretende posicionar a Grok como una solución transversal, desde el coche inteligente hasta el desarrollo de software. Sin embargo, el desafío no es solo técnico, sino reputacional: ¿aceptarán las empresas un sistema que sigue reflejando la visión ideológica de su CEO?

Excelencia técnica vs. dependencia ideológica

Grok 4 representa un salto técnico extraordinario, con una arquitectura multiagente que podría marcar el futuro de la IA generativa. Sus resultados en benchmarks clave lo sitúan como líder temporal en la carrera tecnológica. Pero este avance viene acompañado de riesgos: interferencias ideológicas, fallos de seguridad, falta de transparencia y una gobernanza corporativa centrada en la figura de Musk.

Para los directivos y empresas, Grok 4 es un caso de estudio: una tecnología brillante que, si no se gobierna adecuadamente, puede volverse inviable para entornos profesionales que exigen neutralidad, seguridad y responsabilidad. Si xAI desea competir de forma realista en el mercado corporativo, tendrá que demostrar que puede separar la excelencia técnica del ruido ideológico.