El informe “2025 State of GenAI Report” de Palo Alto Networks revela un alarmante aumento del 890% en el uso de herramientas de inteligencia artificial generativa en organizaciones globales. Esta adopción masiva, aunque impulsada por la mejora en la productividad, ha multiplicado los riesgos de seguridad, evidenciados por un incremento del 14% en incidentes de fuga de datos. La falta de control en el uso de “Shadow AI” y la vulnerabilidad de muchas aplicaciones plantean un desafío crítico para la gobernanza y la protección de datos en el entorno empresarial.

Uso descontrolado de IA generativa multiplica los riesgos

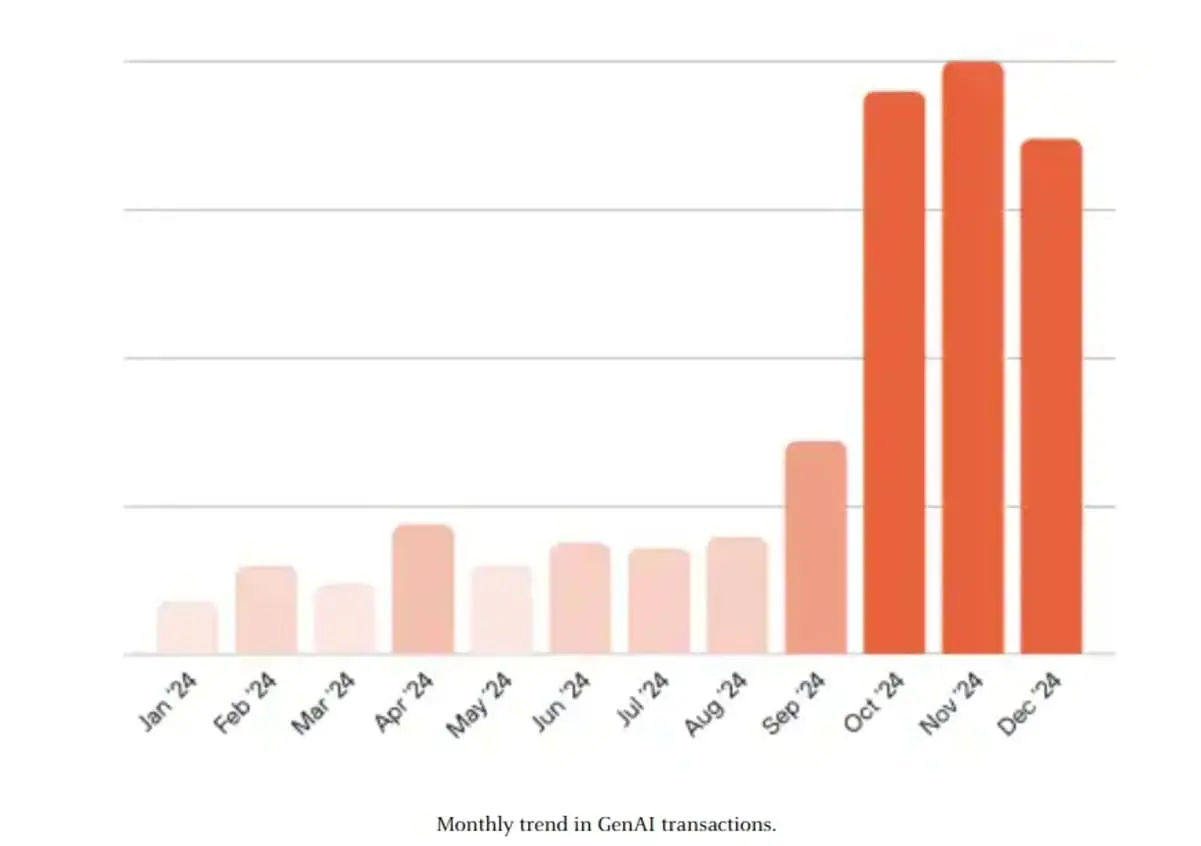

Palo Alto Networks ha publicado su informe 2025 State of GenAI Report, en el que analiza el impacto del uso de inteligencia artificial generativa (IA Gen) en la seguridad empresarial. El estudio se basa en el tráfico observado en más de 7.000 organizaciones globales a lo largo de 2024 y el primer trimestre de 2025. El hallazgo principal: el tráfico vinculado a herramientas de IA generativa ha aumentado un 890%, lo que revela una adopción masiva, pero también una creciente exposición a amenazas.

IA generativa y productividad: un arma de doble filo

El crecimiento de la IA generativa responde a avances significativos en automatización y a mejoras claras en la productividad. Algunas consultoras, como McKinsey, estiman que su impacto económico puede alcanzar hasta un 40% de incremento en eficiencia. Un ejemplo concreto fue el lanzamiento del modelo DeepSeek-R1 en enero de 2025, cuyo uso se disparó un 1.800% en apenas dos meses.

Aumento de incidentes y pérdida de control

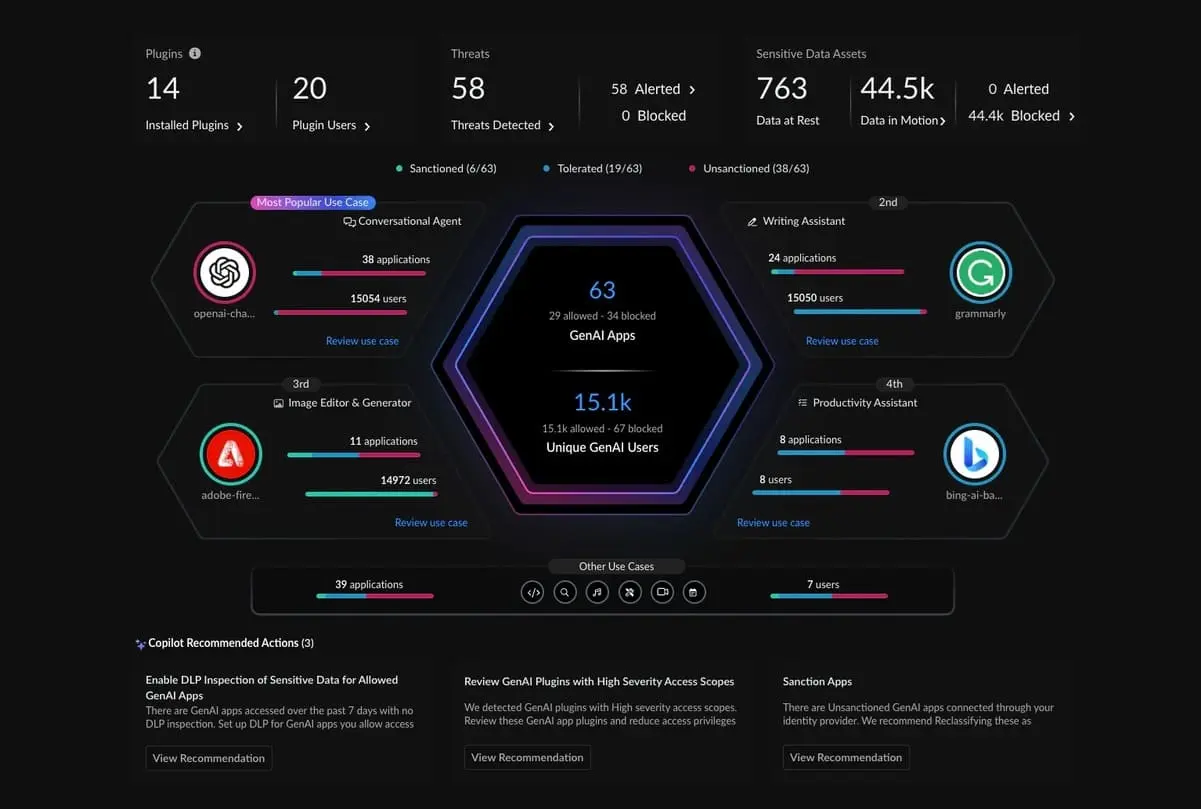

Sin embargo, este auge ha venido acompañado de consecuencias preocupantes. Solo en el primer trimestre de 2025, los incidentes de fuga de datos vinculados a la IA generativa se multiplicaron por 2,5, hasta representar el 14% de todos los incidentes de seguridad registrados. En promedio, cada organización tiene identificadas 66 aplicaciones de IA generativa operando en su red, muchas de ellas sin control ni supervisión.

Shadow AI: la amenaza invisible dentro de las empresas

Uno de los mayores desafíos es el fenómeno conocido como “Shadow AI”: el uso no autorizado de herramientas de IA por parte de empleados sin conocimiento del área de TI. Esta práctica compromete la confidencialidad y dificulta el cumplimiento normativo. En promedio, las empresas gestionan 6,6 aplicaciones de IA generativa de alto riesgo que no están sujetas a políticas claras ni controles adecuados.

¿Qué es Shadow IA?

Shadow IA (o Shadow AI, en inglés) es un término que se refiere al uso no autorizado o no supervisado de herramientas de inteligencia artificial por parte de empleados dentro de una organización, sin el conocimiento o aprobación del departamento de TI o seguridad.

Características clave del fenómeno:

-

Falta de control: Estas herramientas no están gestionadas por la infraestructura oficial de la empresa, lo que impide aplicar políticas de seguridad, cumplimiento o auditoría.

-

Uso personal en entornos corporativos: Empleados pueden utilizar plataformas de IA generativa como ChatGPT, Copilot o herramientas de desarrollo para facilitar su trabajo, sin evaluar los riesgos asociados.

-

Riesgos que implica:

-

Fugas de datos sensibles

-

Violaciones normativas (como GDPR)

-

Exposición a contenido malicioso

-

Pérdida de propiedad intelectual

-

¿Por qué es un problema?

El Shadow IA reduce la visibilidad que tienen las organizaciones sobre cómo se usan sus datos y qué herramientas acceden a ellos. Esto dificulta la gestión de riesgos y pone en peligro la seguridad y el cumplimiento normativo.

Aplicaciones vulnerables a manipulaciones peligrosas

Más del 70% de las aplicaciones evaluadas pueden ser manipuladas mediante ataques de tipo jailbreak, que permiten que generen contenidos peligrosos o inadecuados, como instrucciones ilegales o mensajes ofensivos. Este hallazgo pone de manifiesto la urgencia de fortalecer la seguridad y la ética en el desarrollo de estos sistemas.

Herramientas más utilizadas y sectores líderes

El análisis revela que el 83,8% del tráfico de IA generativa proviene de plataformas de asistencia a la escritura, asistentes conversacionales, buscadores corporativos y entornos de desarrollo. Entre los asistentes de escritura, Grammarly lidera con un 39% del tráfico. En el sector empresarial, Microsoft Copilot y Copilot Studio están presentes en casi el 49% de las organizaciones.

En el caso de España, las herramientas más utilizadas son:

-

Microsoft 365 Copilot (24,1%).

-

Microsoft PowerApps (23,9%).

-

ChatGPT de OpenAI (23,4%).

Los sectores tecnológico e industrial concentran el 39% de las actividades de codificación basadas en IA, lo que añade riesgos relacionados con código malicioso, filtraciones de propiedad intelectual y exposición legal.

Recomendaciones: gobernanza integral de la IA

Para afrontar este escenario, Palo Alto Networks propone un enfoque integral de gobernanza en torno a la IA generativa. Las tres prioridades clave son:

1. Controlar el uso permitido

Establecer políticas claras basadas en perfiles de usuarios, ubicaciones, dispositivos, niveles de riesgo y objetivos empresariales legítimos.

2. Proteger los datos sensibles

Implementar inspección de contenido en tiempo real y políticas centralizadas de seguridad que cubran todo el flujo de datos.

3. Defenderse contra ciberamenazas

Adoptar arquitecturas Zero Trust capaces de detectar y neutralizar malware avanzado y amenazas ocultas en respuestas generadas por IA.

Metodología del informe

El informe se elaboró con datos anónimos recogidos por las plataformas Prisma® Access y Next-Generation Firewall (NGFW), correspondientes a 7.051 clientes de todo el mundo durante 2024. Se analizaron también incidentes DLP entre enero y marzo de 2025, cumpliendo estrictamente los estándares de privacidad.

El informe completo está disponible en la web de Palo Alto Networks, con detalles adicionales sobre amenazas, tendencias y estrategias de mitigación.